동일한 가상악기라도 DAW 가 다르면 다른 소리가 나는 것인가요? Part 2/2 ( DAWs... Do they sound different? )

강좌 ( Lecture )/Tip & etc 2018. 11. 30. 22:41오늘 올리는 글은 강좌라기 보다는 항상 이슈가 되는 몇몇 주제에 대한 Issue Posting 첫번째 편 ( 1-2 : 후반부 ) 입니다. ^^

동일한 가상악기라도 DAW 가 다르면 다른 소리가 나는 것인가요? Part 2/2 ( DAWs... Do they sound different? )

첫번째 Issue Posting 은 [ 동일한 가상악기라도 DAW 가 다르면 다른 소리가 나는 것인가? ] 라는 주제 Part 2/2 입니다. ^_^

이전에 올린 Issue Posting 1-1 에 이어지는 후반부 Part 2/2 부분이기 때문에 이전 글을 먼저 읽으셔야 도움이 되실겁니다. ^^

이 Issue Posting 글은 제 블로그와 큐오넷에 올리기 위해 제작된 것이기 때문에 다른 싸이트나 블로그 또는

카페에 퍼가는 것은 하지 않으셨으면 합니다. ( 제가 직접 다른 싸이트나 블로그에 올리겠으니 예의 지켜 주세요 ^_^ )

강좌에 사용된 영상은 설명의 이해를 돕기 위해 직접 제작한 Youtube 의 영상을 링크했으며

일부 사용된 사진은 인터넷의 오픈된 사진을 사용했습니다. ^^ 혹 문제가 된다면 삭제하도록 하겠습니다.

오늘도 기분 좋은 음악 한곡 듣고 시작할까요? ^_^

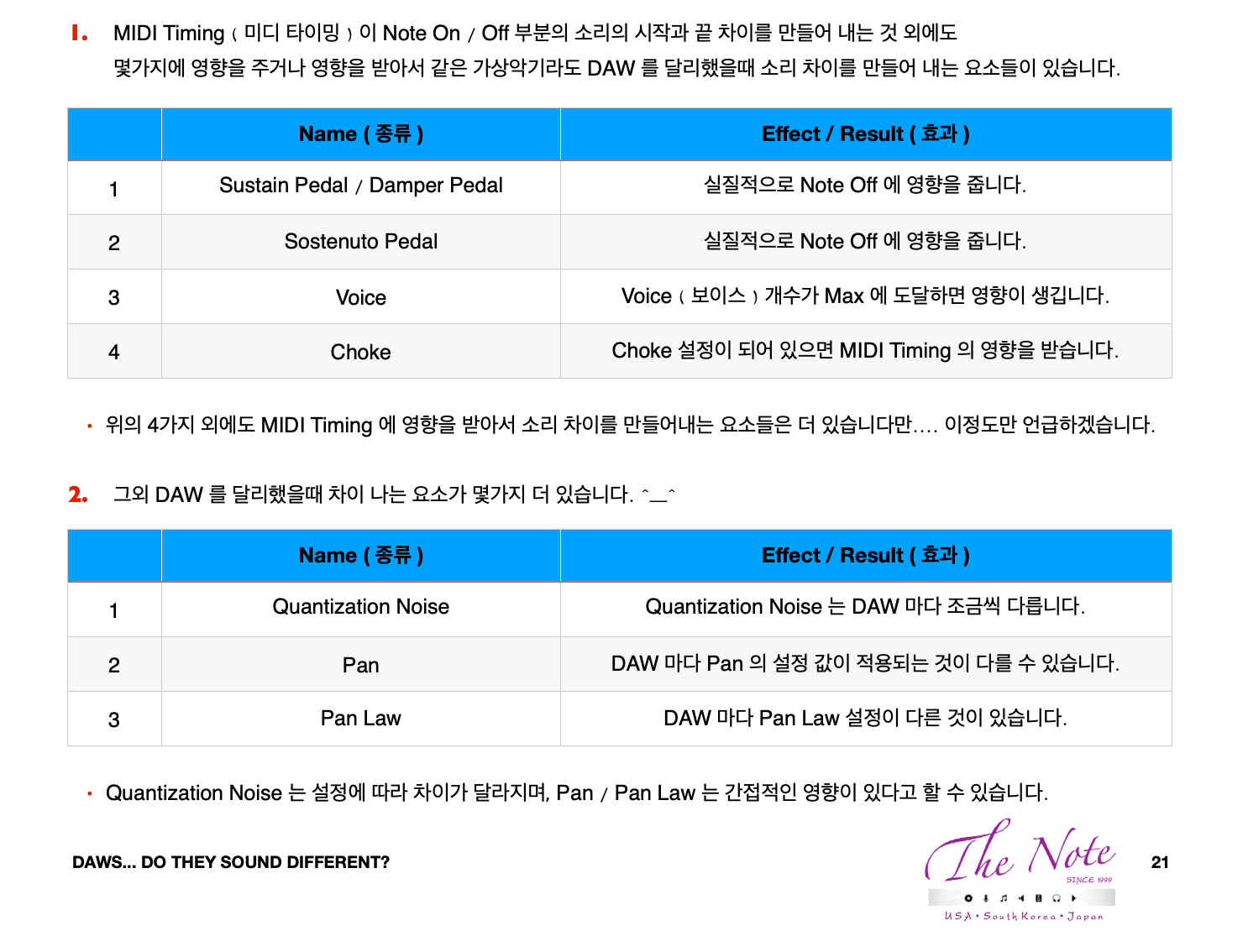

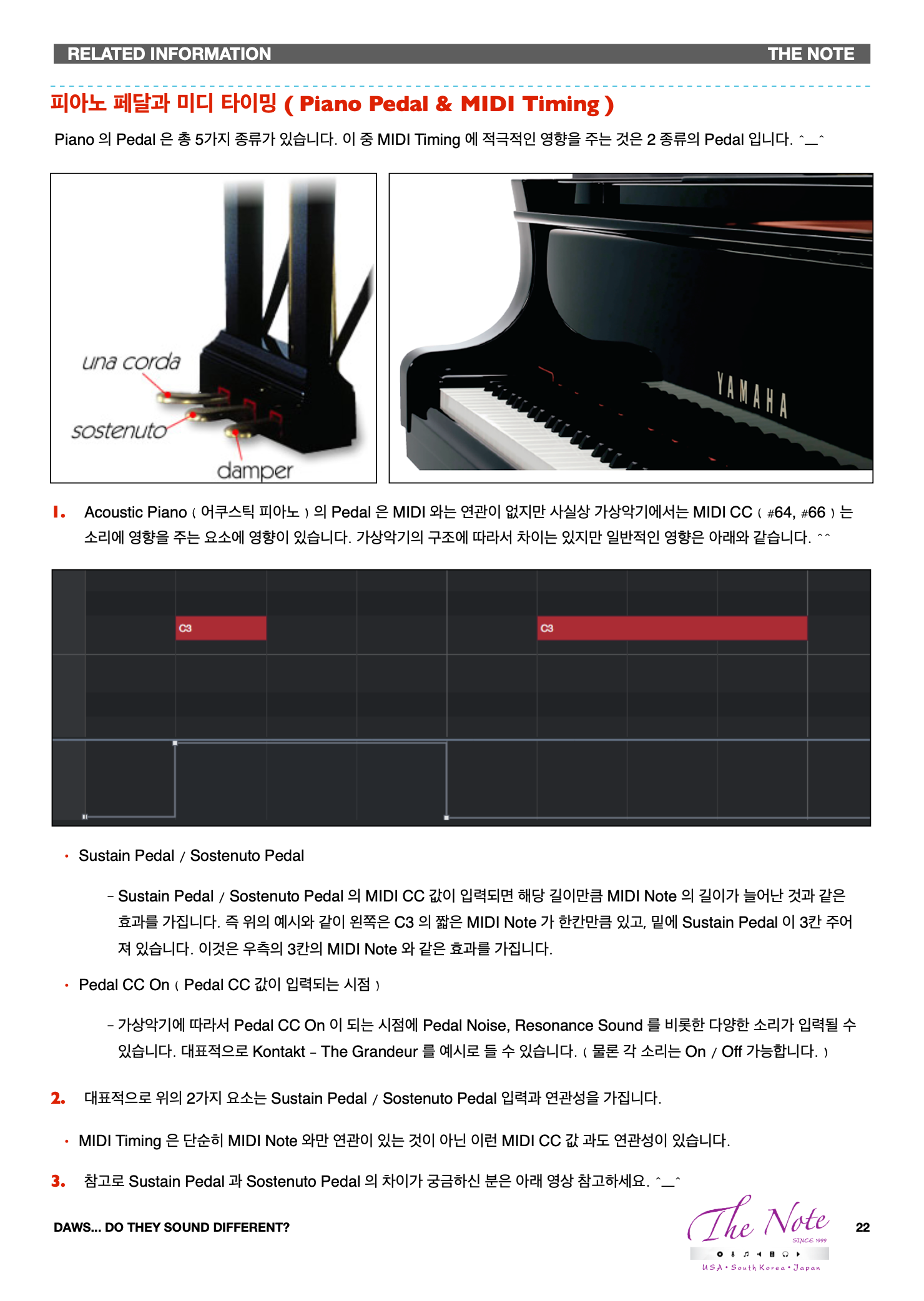

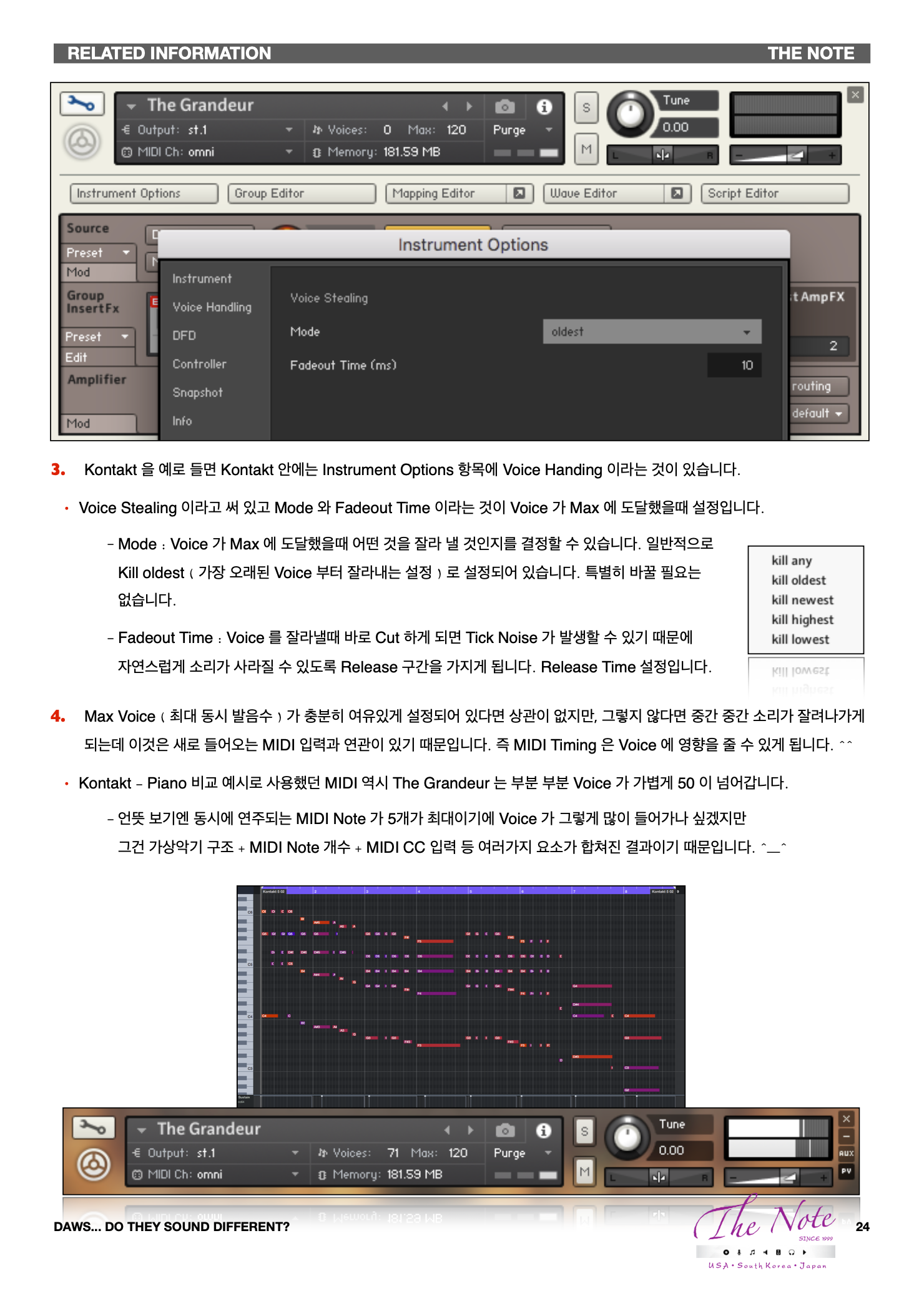

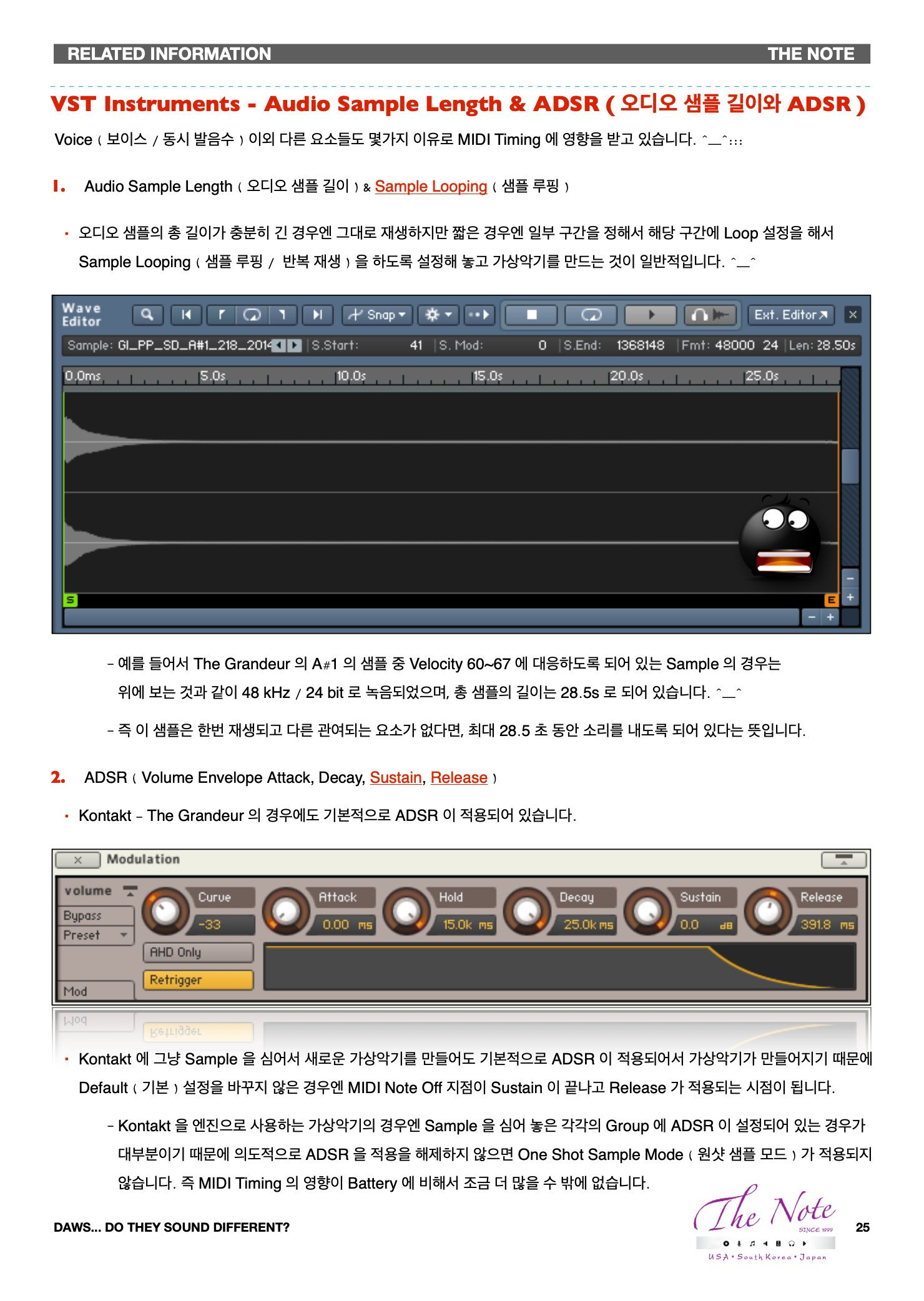

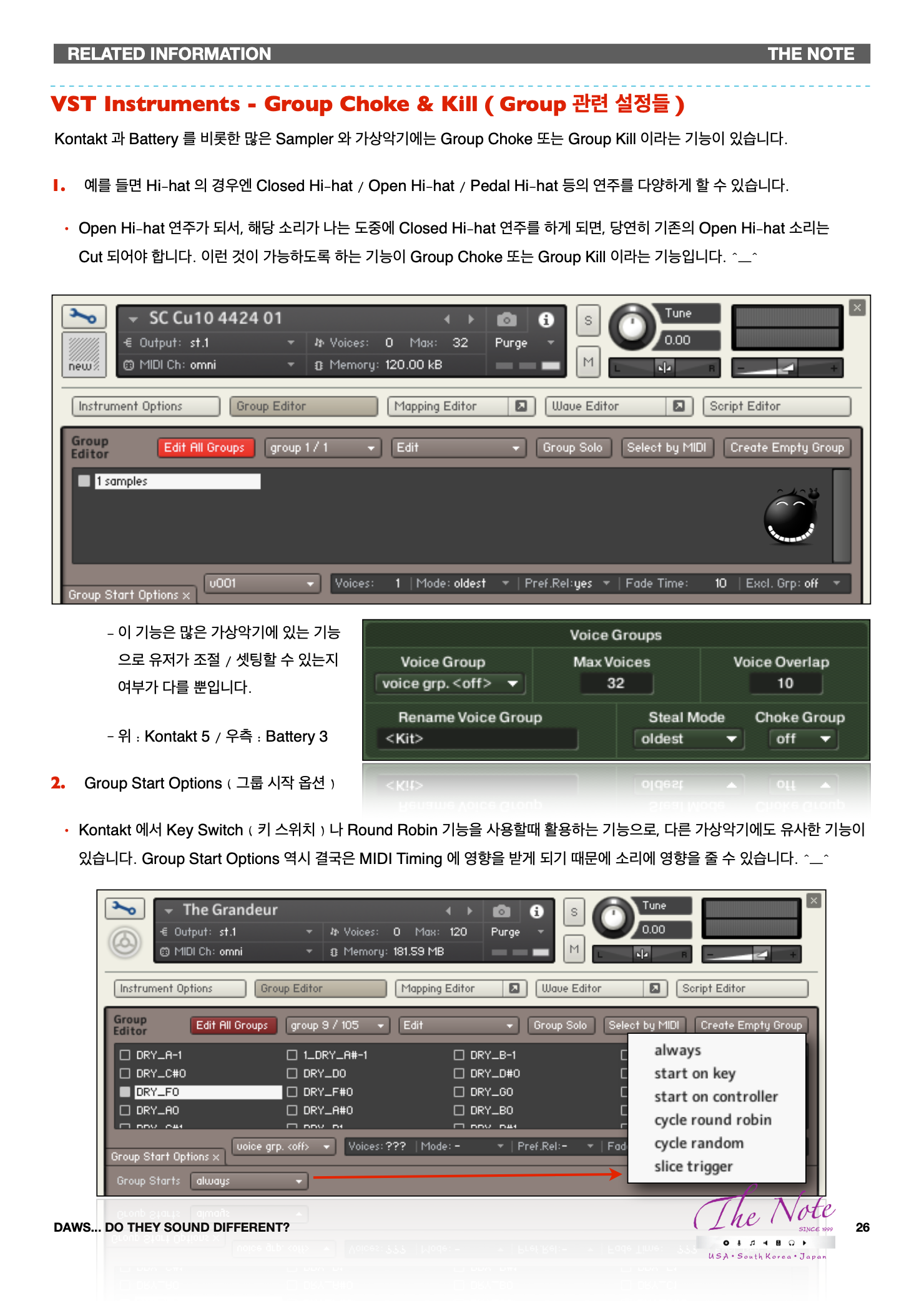

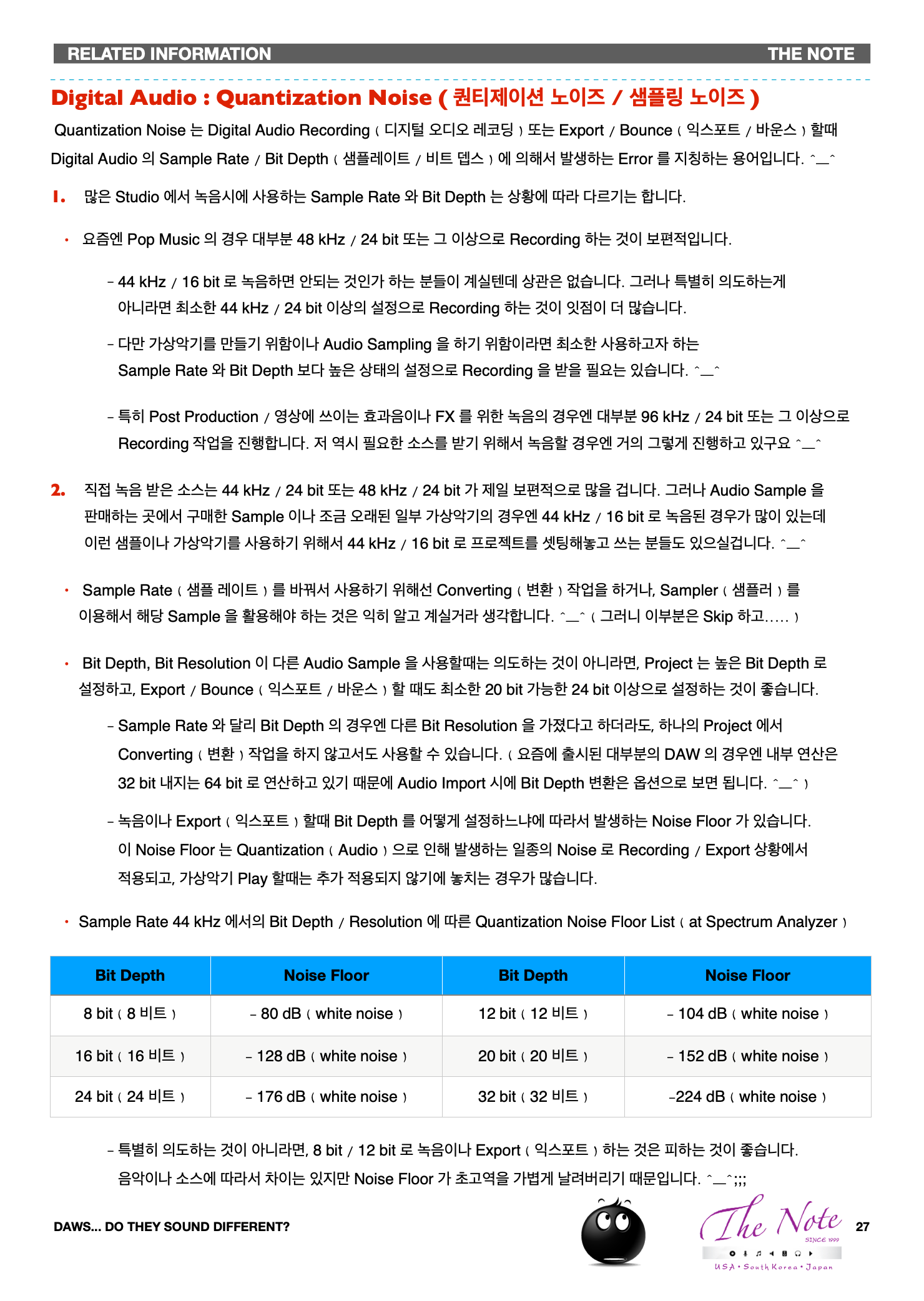

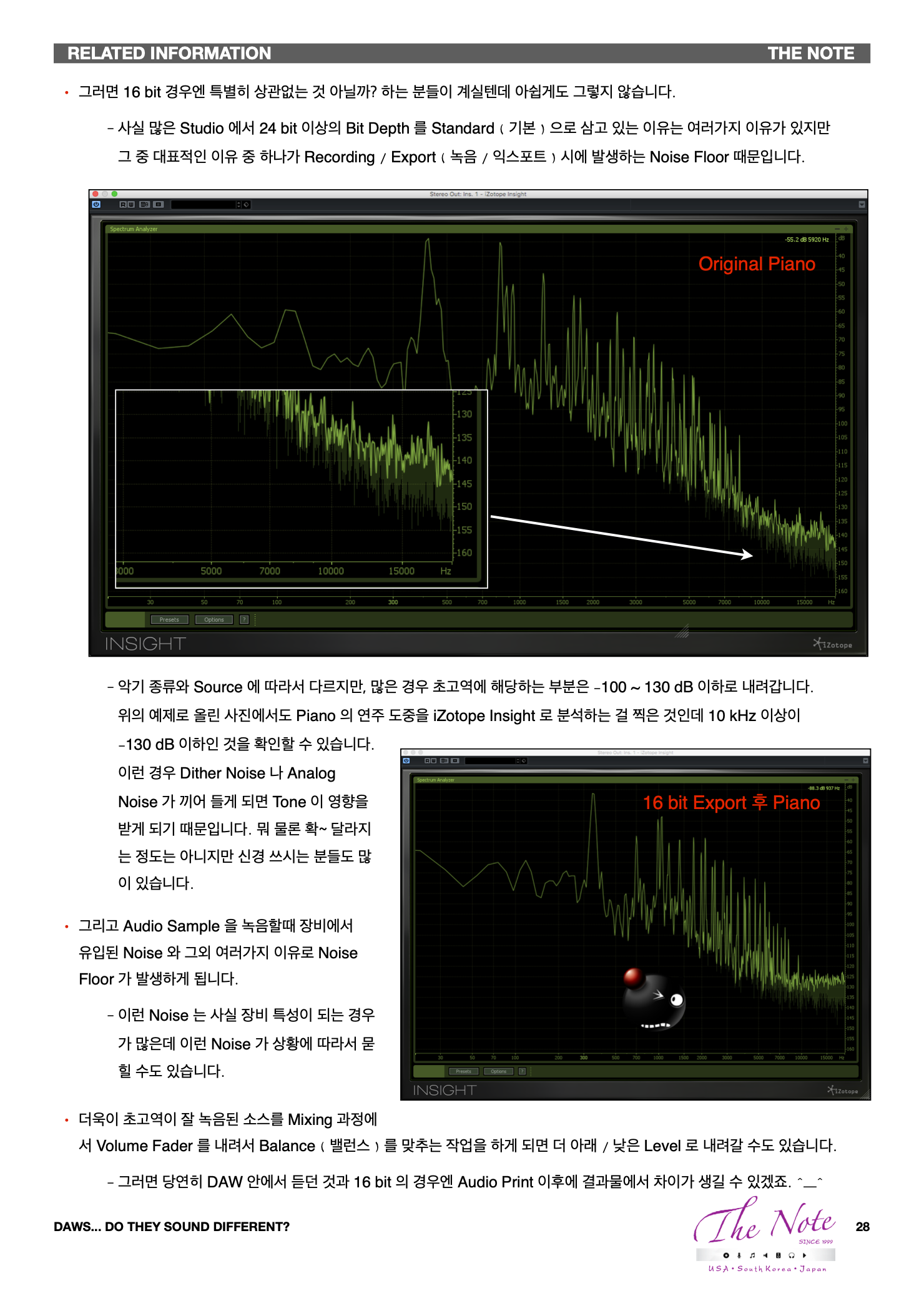

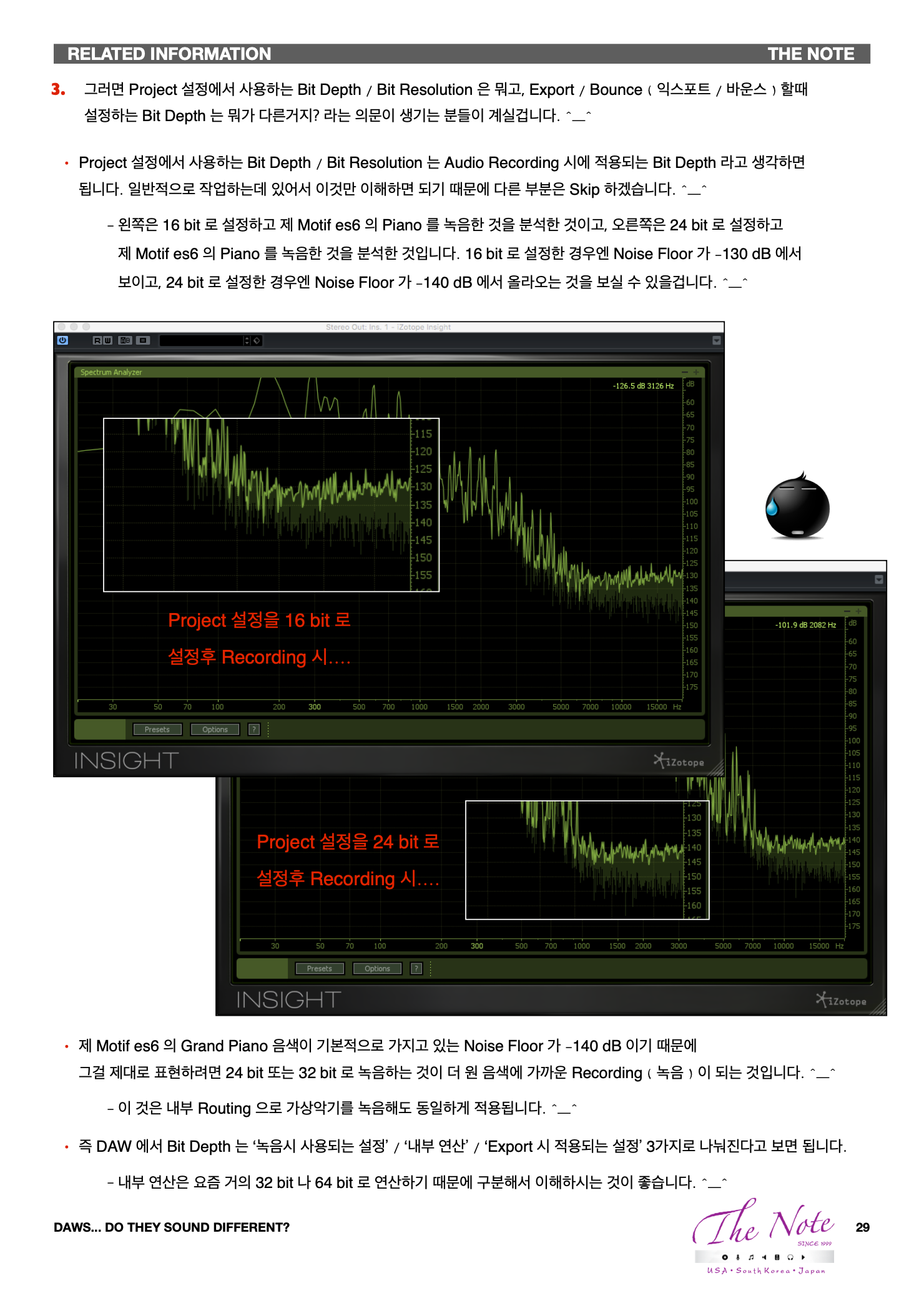

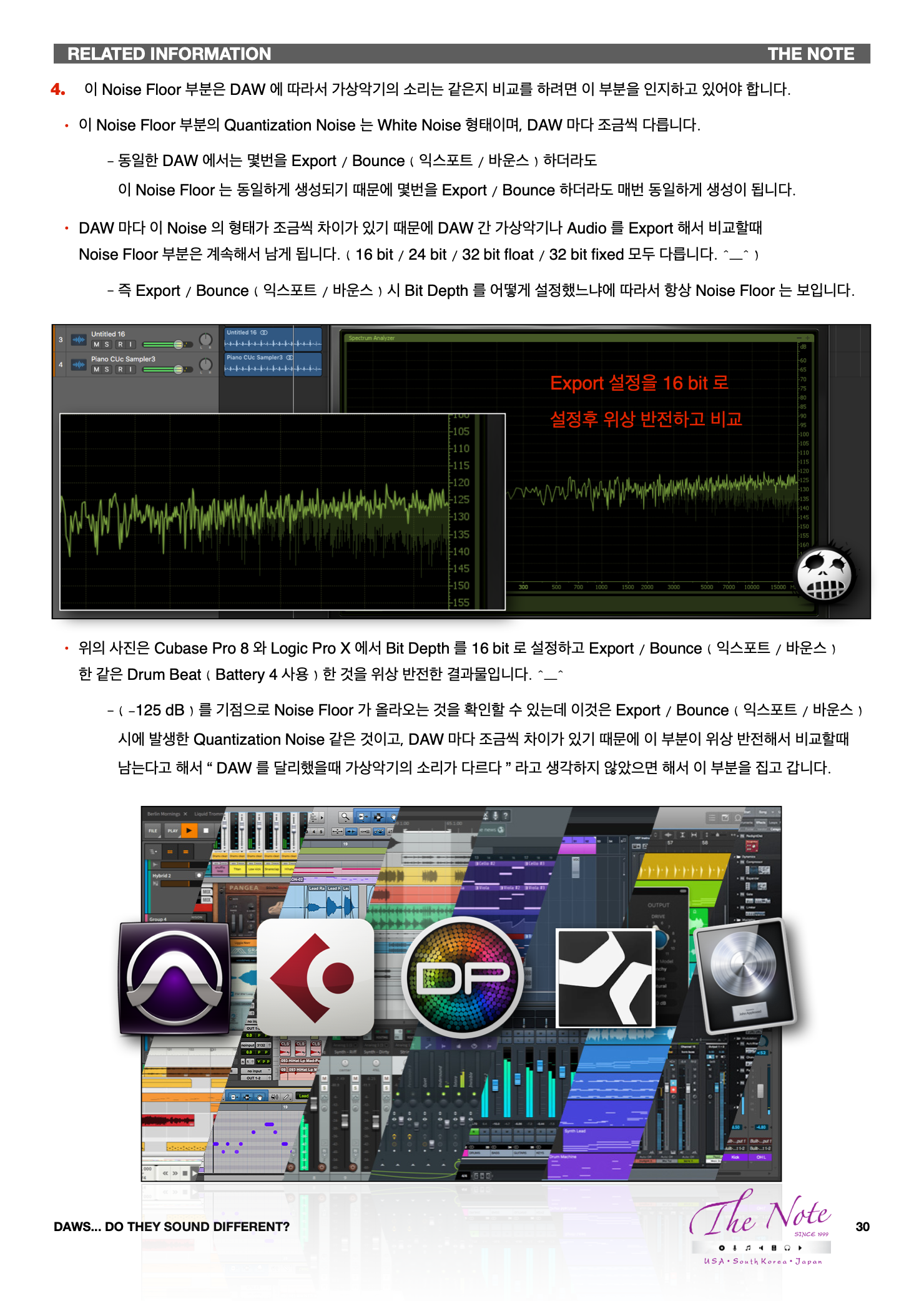

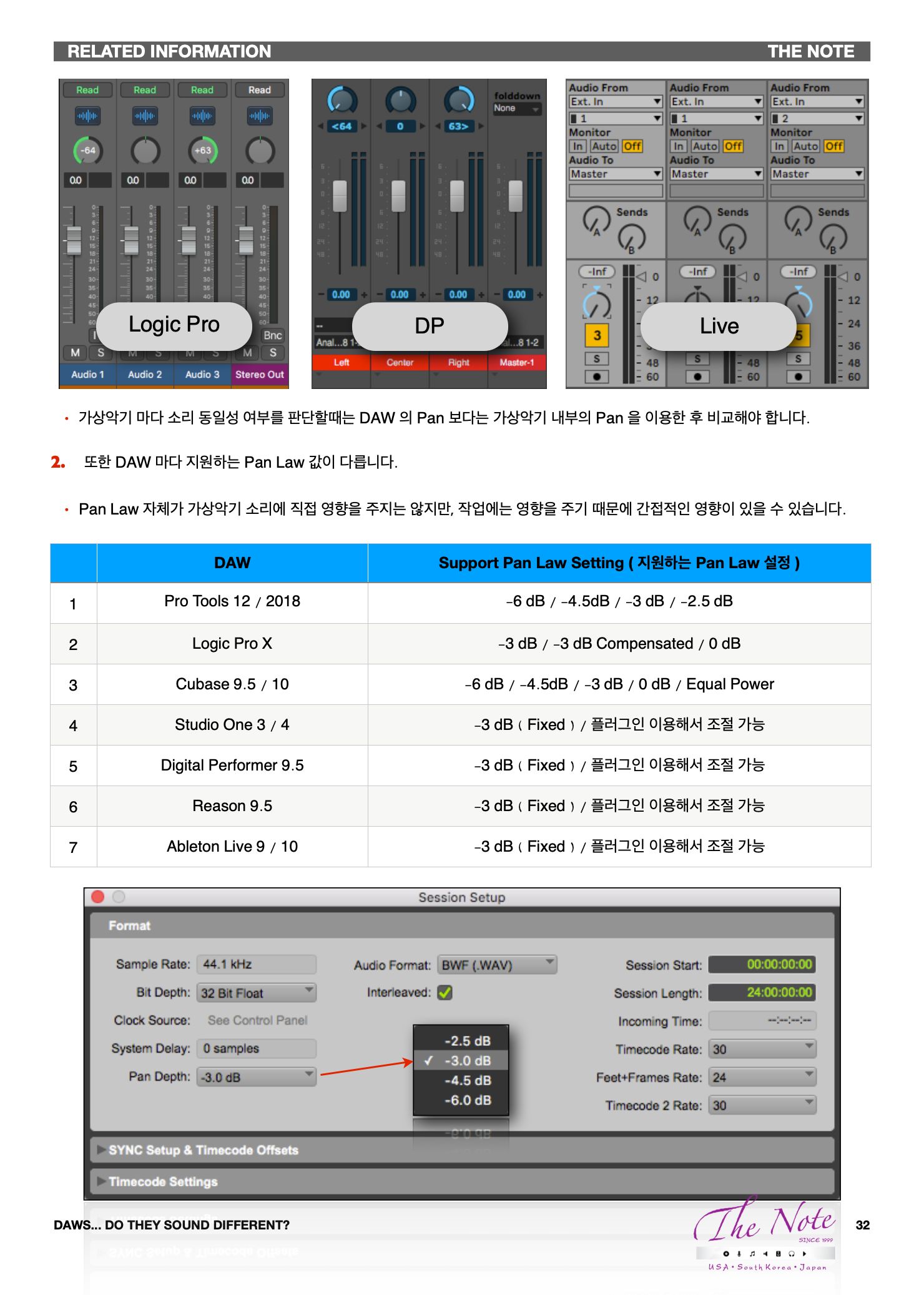

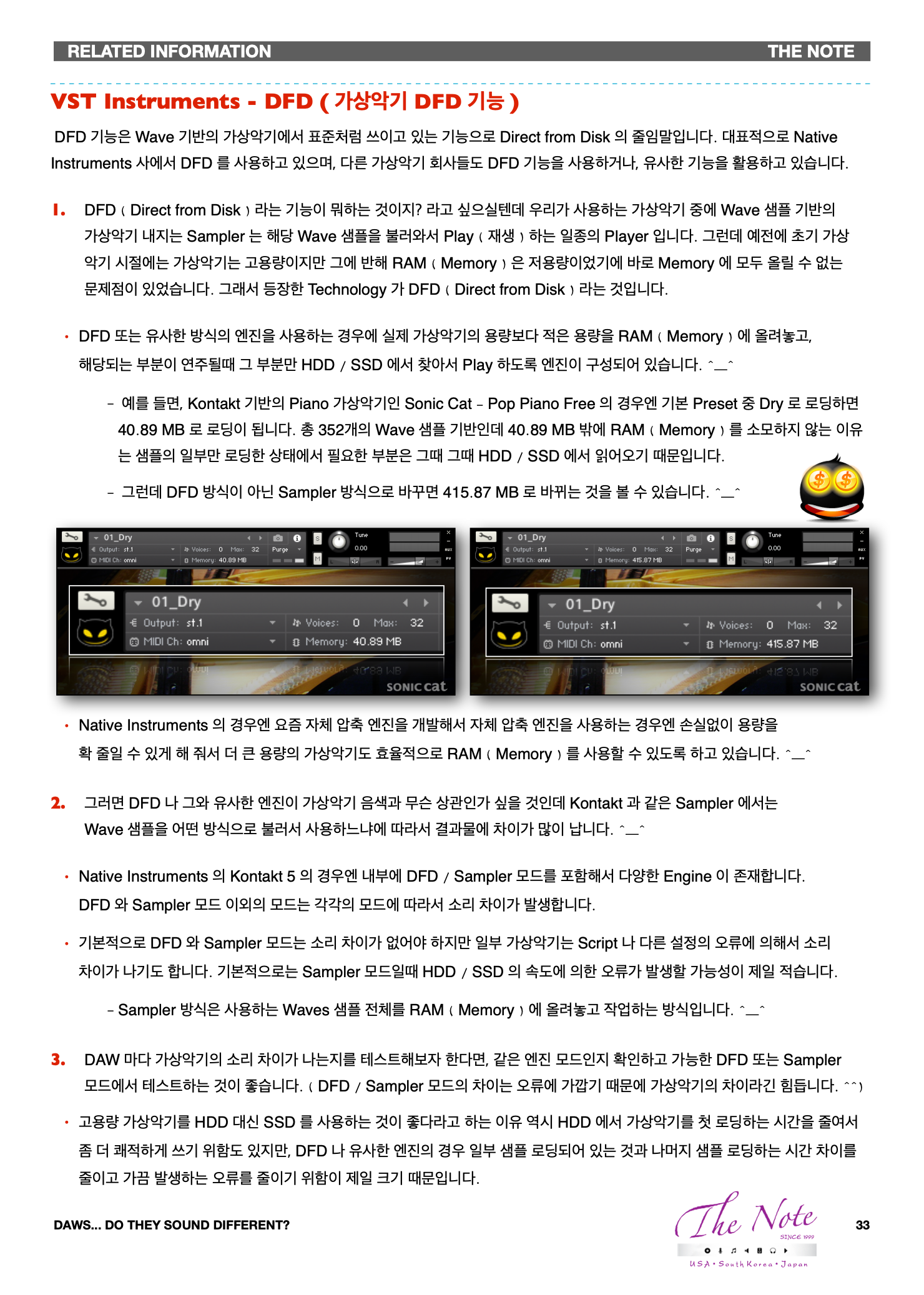

DAWs... Do They sound different? 미디 타이밍 ( MIDI Timing ) 에 영향을 받거나 주는 또 다른 요소는 없나요? DAW 가 달라졌을때 가상악기의 소리는 MIDI Timing 의 영향으로 달라질 수 있습니다. 더불어 몇가지 요소들이 차이를 보입니다. MIDI Timing ( 미디 타이밍 ) 이 Note On / Off 부분의 소리의 시작과 끝 차이를 만들어 내는 것 외에도 몇가지에 영향을 주거나 영향을 받아서 같은 가상악기라도 DAW 를 달리했을때 소리 차이를 만들어 내는 요소들이 있습니다. Name ( 종류 ) Effect / Result ( 효과 ) 1 Sustain Pedal / Damper Pedal 실질적으로 Note Off 에 영향을 줍니다. 2 Sostenuto Pedal 실질적으로 Note Off 에 영향을 줍니다. 3 Voice Voice ( 보이스 ) 개수가 Max 에 도달하면 영향이 생깁니다. 4 Choke Choke 설정이 되어 있으면 MIDI Timing 의 영향을 받습니다. 위의 4가지 외에도 MIDI Timing 에 영향을 받아서 소리 차이를 만들어내는 요소들은 더 있습니다만.... 이정도만 언급하겠습니다. 그외 DAW 를 달리했을때 차이 나는 요소가 몇가지 더 있습니다. ^_^ Name ( 종류 ) Effect / Result ( 효과 ) 1 Quantization Noise Quantization Noise 는 DAW 마다 조금씩 다릅니다. 2 Pan DAW 마다 Pan 의 설정 값이 적용되는 것이 다를 수 있습니다. 3 Pan Law DAW 마다 Pan Law 설정이 다른 것이 있습니다. Quantization Noise 는 설정에 따라 차이가 달라지며, Pan / Pan Law 는 간접적인 영향이 있다고 할 수 있습니다. 피아노 페달과 미디 타이밍 ( Piano Pedal & MIDI Timing ) Piano 의 Pedal 은 총 5가지 종류가 있습니다. 이 중 MIDI Timing 에 적극적인 영향을 주는 것은 2 종류의 Pedal 입니다. ^_^ Acoustic Piano ( 어쿠스틱 피아노 ) 의 Pedal 은 MIDI 와는 연관이 없지만 사실상 가상악기에서는 MIDI CC ( #64, #66 ) 는 소리에 영향을 주는 요소에 영향이 있습니다. 가상악기의 구조에 따라서 차이는 있지만 일반적인 영향은 아래와 같습니다. ^^ Sustain Pedal / Sostenuto Pedal Sustain Pedal / Sostenuto Pedal 의 MIDI CC 값이 입력되면 해당 길이만큼 MIDI Note 의 길이가 늘어난 것과 같은 효과를 가집니다. 즉 위의 예시와 같이 왼쪽은 C3 의 짧은 MIDI Note 가 한칸만큼 있고, 밑에 Sustain Pedal 이 3칸 주어져 있습니다. 이것은 우측의 3칸의 MIDI Note 와 같은 효과를 가집니다. Pedal CC On ( Pedal CC 값이 입력되는 시점 ) 가상악기에 따라서 Pedal CC On 이 되는 시점에 Pedal Noise, Resonance Sound 를 비롯한 다양한 소리가 입력될 수 있습니다. 대표적으로 Kontakt - The Grandeur 를 예시로 들 수 있습니다. ( 물론 각 소리는 On / Off 가능합니다. ) 대표적으로 위의 2가지 요소는 Sustain Pedal / Sostenuto Pedal 입력과 연관성을 가집니다. MIDI Timing 은 단순히 MIDI Note 와만 연관이 있는 것이 아닌 이런 MIDI CC 값 과도 연관성이 있습니다. 참고로 Sustain Pedal 과 Sostenuto Pedal 의 차이가 궁금하신 분은 아래 영상 참고하세요. ^_^ VST Instruments - Voice ( 가상악기 Voice 기능 ) Voice ( 보이스 / 동시 발음수 ) 는 가상악기 뿐 아니라 신디사이저에도 있는 기능이자 컨셉입니다. ^_^ Voice ( 보이스 / 동시 발음수 ) 는 현재 소리가 나고 있는 음에 관여한 Wave 샘플 개수 ( Synth 는 OSC ) 를 지칭합니다. Wave 샘플 기반의 대표적인 샘플러이자 가상악기인 Kontakt 을 예로 들어서 설명해보겠습니다. ^_^ 위에 보면 중간에 Voices 라는 항목이 보일텐데 왼쪽이 현재 소리나는 음에 관여하는 Wave 샘플 개수 그리고 오른쪽이 최대로 소리 날 수 있는 Max Voices ( 최대 동시 발음수 ) 입니다. ^_^ 보통 Voice 가 그냥 건반 누른 수가 아닐까 라고 생각하는 분들도 있는데, 가상악기를 만들때 어떻게 만들었느냐에 따라서 이 Voice 의 수가 천차만별로 달라질 수 있습니다. 예를 들어서 The Grandeur 는 기본적으로 각 Pitch 에 해당되는 Dry, Release, Resonance 그리고 그외 요소들이 Voice 에 영향을 주게 됩니다. ^_^ 하나의 음을 연주하더라도, 건반을 누를때 Dry 의 샘플이 연주되고, 건반에서 손을 뗄때 Release 의 샘플이 연주됩니다. 거기에 Sustain Pedal 을 밟을때 적용되는 샘플, Resonance 항목을 지정해놓았다면 Resonance 항목의 샘플까지 소리가 나게 됩니다. ^_^ ( Noise 항목까지 활성화했으면 더 많은 것들이 소리에 관여하게 됩니다. ) 즉 하나의 음을 연주하기 위해서 최소 2개 이상의 Wave 샘플이 사용된다는 뜻입니다. ^_^ 그러면 Voice 가 가상악기의 소리 차이와 무슨 상관이 있나 할 것입니다. ^_^ 가상악기에서 현재 연주되고 있는 Voice 가 Max 에 도달하게 되면 설정에 따라서 하나이상의 소리가 잘려나가기 때문입니다. Kontakt 을 예로 들면 Kontakt 안에는 Instrument Options 항목에 Voice Handing 이라는 것이 있습니다. Voice Stealing 이라고 써 있고 Mode 와 Fadeout Time 이라는 것이 Voice 가 Max 에 도달했을때 설정입니다. Mode : Voice 가 Max 에 도달했을때 어떤 것을 잘라 낼 것인지를 결정할 수 있습니다. 일반적으로 Kill oldest ( 가장 오래된 Voice 부터 잘라내는 설정 ) 로 설정되어 있습니다. 특별히 바꿀 필요는 없습니다. Fadeout Time : Voice 를 잘라낼때 바로 Cut 하게 되면 Tick Noise 가 발생할 수 있기 때문에 자연스럽게 소리가 사라질 수 있도록 Release 구간을 가지게 됩니다. Release Time 설정입니다. Max Voice ( 최대 동시 발음수 ) 가 충분히 여유있게 설정되어 있다면 상관이 없지만, 그렇지 않다면 중간 중간 소리가 잘려나가게 되는데 이것은 새로 들어오는 MIDI 입력과 연관이 있기 때문입니다. 즉 MIDI Timing 은 Voice 에 영향을 줄 수 있게 됩니다. ^^ Kontakt - Piano 비교 예시로 사용했던 MIDI 역시 The Grandeur 는 부분 부분 Voice 가 가볍게 50 이 넘어갑니다. 언뜻 보기엔 동시에 연주되는 MIDI Note 가 5개가 최대이기에 Voice 가 그렇게 많이 들어가나 싶겠지만 그건 가상악기 구조 + MIDI Note 개수 + MIDI CC 입력 등 여러가지 요소가 합쳐진 결과이기 때문입니다. ^_^ VST Instruments - Audio Sample Length & ADSR ( 오디오 샘플 길이와 ADSR ) Voice ( 보이스 / 동시 발음수 ) 이외 다른 요소들도 몇가지 이유로 MIDI Timing 에 영향을 받고 있습니다. ^_^::: Audio Sample Length ( 오디오 샘플 길이 ) & Sample Looping ( 샘플 루핑 ) 오디오 샘플의 총 길이가 충분히 긴 경우엔 그대로 재생하지만 짧은 경우엔 일부 구간을 정해서 해당 구간에 Loop 설정을 해서 Sample Looping ( 샘플 루핑 / 반복 재생 ) 을 하도록 설정해 놓고 가상악기를 만드는 것이 일반적입니다. ^_^ 예를 들어서 The Grandeur 의 A#1 의 샘플 중 Velocity 60~67 에 대응하도록 되어 있는 Sample 의 경우는 위에 보는 것과 같이 48 kHz / 24 bit 로 녹음되었으며, 총 샘플의 길이는 28.5s 로 되어 있습니다. ^_^ 즉 이 샘플은 한번 재생되고 다른 관여되는 요소가 없다면, 최대 28.5 초 동안 소리를 내도록 되어 있다는 뜻입니다. ADSR ( Volume Envelope Attack, Decay, Sustain, Release ) Kontakt - The Grandeur 의 경우에도 기본적으로 ADSR 이 적용되어 있습니다. Kontakt 에 그냥 Sample 을 심어서 새로운 가상악기를 만들어도 기본적으로 ADSR 이 적용되어서 가상악기가 만들어지기 때문에 Default ( 기본 ) 설정을 바꾸지 않은 경우엔 MIDI Note Off 지점이 Sustain 이 끝나고 Release 가 적용되는 시점이 됩니다. Kontakt 을 엔진으로 사용하는 가상악기의 경우엔 Sample 을 심어 놓은 각각의 Group 에 ADSR 이 설정되어 있는 경우가 대부분이기 때문에 의도적으로 ADSR 을 적용을 해제하지 않으면 One Shot Sample Mode ( 원샷 샘플 모드 ) 가 적용되지 않습니다. 즉 MIDI Timing 의 영향이 Battery 에 비해서 조금 더 많을 수 밖에 없습니다. VST Instruments - Group Choke & Kill ( Group 관련 설정들 ) Kontakt 과 Battery 를 비롯한 많은 Sampler 와 가상악기에는 Group Choke 또는 Group Kill 이라는 기능이 있습니다. 예를 들면 Hi-hat 의 경우엔 Closed Hi-hat / Open Hi-hat / Pedal Hi-hat 등의 연주를 다양하게 할 수 있습니다. Open Hi-hat 연주가 되서, 해당 소리가 나는 도중에 Closed Hi-hat 연주를 하게 되면, 당연히 기존의 Open Hi-hat 소리는 Cut 되어야 합니다. 이런 것이 가능하도록 하는 기능이 Group Choke 또는 Group Kill 이라는 기능입니다. ^_^ 이 기능은 많은 가상악기에 있는 기능으로 유저가 조절 / 셋팅할 수 있는지 여부가 다를 뿐입니다. 위 : Kontakt 5 / 우측 : Battery 3 Group Start Options ( 그룹 시작 옵션 ) Kontakt 에서 Key Switch ( 키 스위치 ) 나 Round Robin 기능을 사용할때 활용하는 기능으로, 다른 가상악기에도 유사한 기능이 있습니다. Group Start Options 역시 결국은 MIDI Timing 에 영향을 받게 되기 때문에 소리에 영향을 줄 수 있습니다. ^_^ Digital Audio : Quantization Noise ( 퀀티제이션 노이즈 / 샘플링 노이즈 ) Quantization Noise 는 Digital Audio Recording ( 디지털 오디오 레코딩 ) 또는 Export / Bounce ( 익스포트 / 바운스 ) 할때 Digital Audio 의 Sample Rate / Bit Depth ( 샘플레이트 / 비트 뎁스 ) 에 의해서 발생하는 Error 를 지칭하는 용어입니다. ^_^ 많은 Studio 에서 녹음시에 사용하는 Sample Rate 와 Bit Depth 는 상황에 따라 다르기는 합니다. 요즘엔 Pop Music 의 경우 대부분 48 kHz / 24 bit 또는 그 이상으로 Recording 하는 것이 보편적입니다. 44 kHz / 16 bit 로 녹음하면 안되는 것인가 하는 분들이 계실텐데 상관은 없습니다. 그러나 특별히 의도하는게 아니라면 최소한 44 kHz / 24 bit 이상의 설정으로 Recording 할 필요하는 것이 잇점이 더 많습니다. 다만 가상악기를 만들기 위함이나 Audio Sampling 을 하기 위함이라면 최소한 사용하고자 하는 Sample Rate 와 Bit Depth 보다 높은 상태의 설정으로 Recording 을 받을 필요는 있습니다. ^_^ 특히 Post Production / 영상에 쓰이는 효과음이나 FX 를 위한 녹음의 경우엔 대부분 96 kHz / 24 bit 또는 그 이상으로 Recording 작업을 진행합니다. 저 역시 필요한 소스를 받기 위해서 녹음할 경우엔 거의 그렇게 진행하고 있구요 ^_^ 직접 녹음 받은 소스는 44 kHz / 24 bit 또는 48 kHz / 24 bit 가 제일 보편적으로 많을 겁니다. 그러나 Audio Sample 을 판매하는 곳에서 구매한 Sample 이나 조금 오래된 일부 가상악기의 경우엔 44 kHz / 16 bit 로 녹음된 경우가 많이 있는데 이런 샘플이나 가상악기를 사용하기 위해서 44 kHz / 16 bit 로 프로젝트를 셋팅해놓고 쓰는 분들도 있으실겁니다. ^_^ Sample Rate ( 샘플 레이트 ) 를 바꿔서 사용하기 위해선 Converting ( 변환 ) 작업을 하거나, Sampler ( 샘플러 ) 를 이용해서 해당 Sample 을 활용해야 하는 것은 익히 알고 계실거라 생각합니다. ^_^ ( 그러니 이부분은 Skip 하고..... ) Bit Depth, Bit Resolution 이 다른 Audio Sample 을 사용할때는 의도하는 것이 아니라면, Project 는 높은 Bit Depth 로 설정하고, Export / Bounce ( 익스포트 / 바운스 ) 할 때도 최소한 20 bit 가능한 24 bit 이상으로 설정하는 것이 좋습니다. Sample Rate 와 달리 Bit Depth 의 경우엔 다른 Bit Resolution 을 가졌다고 하더라도, 하나의 Project 에서 Converting ( 변환 ) 작업을 하지 않고서도 사용할 수 있습니다. ( 요즘에 출시된 대부분의 DAW 의 경우엔 내부 연산은 32 bit 내지는 64 bit 로 연산하고 있기 때문에 Audio Import 시에 Bit Depth 변환은 옵션으로 보면 됩니다. ^_^ ) 녹음이나 Export ( 익스포트 ) 할때 Bit Depth 를 어떻게 설정하느냐에 따라서 발생하는 Noise Floor 가 있습니다. 이 Noise Floor 는 Quantization ( Audio ) 으로 인해 발생하는 일종의 Noise 로 Recording / Export 상황에서 적용되고, 가상악기 Play 할때는 추가 적용되지 않기에 놓치는 경우가 많습니다. Sample Rate 44 kHz 에서의 Bit Depth / Resolution 을 달리했을때의 Quantization Noise Floor List Bit Depth Noise Floor Bit Depth Noise Floor 8 bit ( 8 비트 ) - 80 dB ( white noise ) 12 bit ( 12 비트 ) - 104 dB ( white noise ) 16 bit ( 16 비트 ) - 128 dB ( white noise ) 20 bit ( 20 비트 ) - 152 dB ( white noise ) 24 bit ( 24 비트 ) - 176 dB ( white noise ) 32 bit ( 32 비트 ) -224 dB ( white noise ) 특별히 의도하는 것이 아니라면, 8 bit / 12 bit 로 녹음이나 Export ( 익스포트 ) 하는 것은 피하는 것이 좋습니다. 음악이나 소스에 따라서 차이는 있지만 Noise Floor 가 초고역을 가볍게 날려버리기 때문입니다. ^_^;;; 그러면 16 bit 경우엔 특별히 상관없는 것 아닐까? 하는 분들이 계실텐데 아쉽게도 그렇지 않습니다. 사실 많은 Studio 에서 24 bit 이상의 Bit Depth 를 Standard ( 기본 ) 으로 삼고 있는 이유는 여러가지 이유가 있지만 그 중 대표적인 이유 중 하나가 Recording / Export ( 녹음 / 익스포트 ) 시에 발생하는 Noise Floor 때문입니다. 악기 종류와 Source 에 따라서 다르지만, 많은 경우 초고역에 해당하는 부분은 -100 ~ 130 dB 이하로 내려갑니다. 위의 예제로 올린 사진에서도 Piano 의 연주 도중을 iZotope Insight 로 분석하는 걸 찍은 것인데 10 kHz 이상이 -130 dB 이하인 것을 확인할 수 있습니다. 이런 경우 Dither Noise 나 Analog Noise 가 끼어 들게 되면 Tone 이 영향을 받게 되기 때문입니다. 뭐 물론 확~ 달라지는 정도는 아니지만 신경 쓰시는 분들도 많이 있습니다. 그리고 Audio Sample 을 녹음할때 장비에서 유입된 Noise 와 그외 여러가지 이유로 Noise Floor 가 발생하게 됩니다. 이런 Noise 는 사실 장비 특성이 되는 경우가 많은데 이런 Noise 가 상황에 따라서 묻힐 수도 있습니다. 더욱이 초고역이 잘 녹음된 소스를 Mixing 과정에서 Volume Fader 를 내려서 Balance ( 밸런스 ) 를 맞추는 작업을 하게 되면 더 아래 / 낮은 Level 로 내려갈 수도 있습니다. 그러면 당연히 DAW 안에서 듣던 것과 16 bit 의 경우엔 Audio Print 이후에 결과물에서 차이가 생길 수 있겠죠. ^_^ 그러면 Project 설정에서 사용하는 Bit Depth / Bit Resolution 은 뭐고, Export / Bounce ( 익스포트 / 바운스 ) 할때 설정하는 Bit Depth 는 뭐가 다른거지? 라는 의문이 생기는 분들이 계실겁니다. ^_^ Project 설정에서 사용하는 Bit Depth / Bit Resolution 는 Audio Recording 시에 적용되는 Bit Depth 라고 생각하면 됩니다. 일반적으로 작업하는데 있어서 이것만 이해하면 되기 때문에 다른 부분은 Skip 하겠습니다. ^_^ 왼쪽은 16 bit 로 설정하고 제 Motif es6 의 Piano 를 녹음한 것을 분석한 것이고, 오른쪽은 24 bit 로 설정하고 제 Motif es6 의 Piano 를 녹음한 것을 분석한 것입니다. 16 bit 로 설정한 경우엔 Noise Floor 가 -130 dB 에서 보이고, 24 bit 로 설정한 경우엔 Noise Floor 가 -140 dB 에서 올라오는 것을 보실 수 있을겁니다. ^_^ 제 Motif es6 의 Grand Piano 음색이 기본적으로 가지고 있는 Noise Floor 가 -140 dB 이기 때문에 그걸 제대로 표현하려면 24 bit 또는 32 bit 로 녹음하는 것이 더 원 음색에 가까운 Recording ( 녹음 ) 이 되는 것입니다. ^_^ 이 것은 내부 Routing 으로 가상악기를 녹음해도 동일하게 적용됩니다. ^_^ 즉 DAW 에서 Bit Depth 는 ‘녹음시 사용되는 설정’ / ‘내부 연산’ / ‘Export 시 적용되는 설정’ 3가지로 나눠진다고 보면 됩니다. 내부 연산은 요즘 거의 32 bit 나 64 bit 로 연산하기 때문에 구분해서 이해하시는 것이 좋습니다. ^_^ 이 Noise Floor 부분은 DAW 에 따라서 가상악기의 소리는 같은지 비교를 하려면 이 부분을 인지하고 있어야 합니다. 이 Noise Floor 부분의 Quantization Noise 는 White Noise 형태이며, DAW 마다 조금씩 다릅니다. 동일한 DAW 에서는 몇번을 Export / Bounce ( 익스포트 / 바운스 ) 하더라도 이 Noise Floor 는 동일하게 생성되기 때문에 몇번을 Export / Bounce 하더라도 매번 동일하게 생성이 됩니다. DAW 마다 이 Noise 의 형태가 조금씩 차이가 있기 때문에 DAW 간 가상악기나 Audio 를 Export 해서 비교할때 Noise Floor 부분은 계속해서 남게 됩니다. ( 16 bit / 24 bit / 32 bit float / 32 bit fixed 모두 다릅니다. ^_^ ) 즉 Export / Bounce ( 익스포트 / 바운스 ) 시 Bit Depth 를 어떻게 설정했느냐에 따라서 항상 Noise Floor 는 보입니다. 위의 사진은 Cubase Pro 8 와 Logic Pro X 에서 Bit Depth 를 16 bit 로 설정하고 Export / Bounce ( 익스포트 / 바운스 ) 한 같은 Drum Beat ( Battery 4 사용 ) 한 것을 위상 반전한 결과물입니다. ^_^ ( -125 dB ) 를 기점으로 Noise Floor 가 올라오는 것을 확인할 수 있는데 이것은 Export / Bounce ( 익스포트 / 바운스 ) 시에 발생한 Quantization Noise 같은 것이고, DAW 마다 조금씩 차이가 있기 때문에 이 부분이 위상 반전해서 비교할때 남는다고 해서 “ DAW 를 달리했을때 가상악기의 소리가 다르다 ” 라고 생각하지 않았으면 해서 이 부분을 집고 갑니다. Pan & Pan Law ( 팬 설정 & Pan Law ) 같은 가상악기를 사용했더라도 DAW 에 따라서 Pan 과 Pan Law 에 따라서 직/간접적으로 소리 차이를 만들 수 있습니다. 사실 Pan 과 Pan Law 설정은 가상악기 자체에는 영향이 없지만 각각의 DAW 를 사용하는데 있어서 간접적으로 차이를 만듭니다. DAW 마다 Pan 을 조절하는 값이 다릅니다. 정확히는 크게 3가지 종류로 나눠집니다. Pan Range : R 100 ~ L 100 Pan Range : R 64 ~ L 63 Range : R 50 ~ L 50 Cubase Reason Logic Pro Ableton Live Pro Tools Studio One Digital Performer 즉 Pan 값을 R30, L15 이런 식으로 적어서 비교하게 되면, 실제로는 다른 Pan 값이 되기도 합니다. 가상악기 마다 소리 동일성 여부를 판단할때는 DAW 의 Pan 보다는 가상악기 내부의 Pan 을 이용한 후 비교해야 합니다. 또한 DAW 마다 지원하는 Pan Law 값이 다릅니다. Pan Law 자체가 가상악기 소리에 직접 영향을 주지는 않지만, 작업에는 영향을 주기 때문에 간접적인 영향이 있을 수 있습니다. DAW Support Pan Law Setting ( 지원하는 Pan Law 설정 ) 1 Pro Tools 12 / 2018 -6 dB / -4.5dB / -3 dB / -2.5 dB 2 Logic Pro X -3 dB / -3 dB Compensated / 0 dB 3 Cubase 9.5 / 10 -6 dB / -4.5dB / -3 dB / 0 dB / Equal Power 4 Studio One 3 / 4 -3 dB ( Fixed ) / 플러그인 이용해서 조절 가능 5 Digital Performer 9.5 -3 dB ( Fixed ) / 플러그인 이용해서 조절 가능 6 Reason 9.5 -3 dB ( Fixed ) / 플러그인 이용해서 조절 가능 7 Ableton Live 9 / 10 -3 dB ( Fixed ) / 플러그인 이용해서 조절 가능 VST Instruments - DFD ( 가상악기 DFD 기능 ) DFD 기능은 Wave 기반의 가상악기에서 표준처럼 쓰이고 있는 기능으로 Direct from Disk 의 줄임말입니다. 대표적으로 Native Instruments 사에서 DFD 를 사용하고 있으며, 다른 가상악기 회사들도 DFD 기능을 사용하거나, 유사한 기능을 활용하고 있습니다. DFD ( Direct from Disk ) 라는 기능이 뭐하는 것이지? 라고 싶으실텐데 우리가 사용하는 가상악기 중에 Wave 샘플 기반의 가상악기 내지는 Sampler 는 해당 Wave 샘플을 불러와서 Play ( 재생 ) 하는 일종의 Player 입니다. 그런데 예전에 초기 가상악기 시절에는 가상악기는 고용량이지만 그에 반해 RAM ( Memory ) 은 저용량이었기에 바로 Memory 에 모두 올릴 수 없는 문제점이 있었습니다. 그래서 등장한 Technology 가 DFD ( Direct from Disk ) 라는 것입니다. DFD 또는 유사한 방식의 엔진을 사용하는 경우에 실제 가상악기의 용량보다 적은 용량을 RAM ( Memory ) 에 올려놓고, 해당되는 부분이 연주될때 그 부분만 HDD / SSD 에서 찾아서 Play 하도록 엔진이 구성되어 있습니다. ^_^ 예를 들면, Kontakt 기반의 Piano 가상악기인 Sonic Cat - Pop Piano Free 의 경우엔 기본 Preset 중 Dry 로 로딩하면 40.89 MB 로 로딩이 됩니다. 총 352개의 Wave 샘플 기반인데 40.89 MB 밖에 RAM ( Memory ) 를 소모하지 않는 이유는 샘플의 일부만 로딩한 상태에서 필요한 부분은 그때 그때 HDD / SSD 에서 읽어오기 때문입니다. 그런데 DFD 방식이 아닌 Sampler 방식으로 바꾸면 415.87 MB 로 바뀌는 것을 볼 수 있습니다. ^_^ Native Instruments 의 경우엔 요즘 자체 압축 엔진을 개발해서 자체 압축 엔진을 사용하는 경우엔 손실없이 용량을 확 줄일 수 있게 해 줘서 더 큰 용량의 가상악기도 효율적으로 RAM ( Memory ) 를 사용할 수 있도록 하고 있습니다. ^_^ 그러면 DFD 나 그와 유사한 엔진이 가상악기 음색과 무슨 상관인가 싶을 것인데 Kontakt 과 같은 Sampler 에서는 Wave 샘플을 어떤 방식으로 불러서 사용하느냐에 따라서 결과물에 차이가 많이 납니다. ^_^ Native Instruments 의 Kontakt 5 의 경우엔 내부에 DFD / Sampler 모드를 포함해서 다양한 Engine 이 존재합니다. DFD 와 Sampler 모드 이외의 모드는 각각의 모드에 따라서 소리 차이가 발생합니다. 기본적으로 DFD 와 Sampler 모드는 소리 차이가 없어야 하지만 일부 가상악기는 Script 나 다른 설정의 오류에 의해서 소리 차이가 나기도 합니다. 기본적으로는 Sampler 모드일때 HDD / SSD 의 속도에 의한 오류가 발생할 가능성이 제일 적습니다. Sampler 방식은 사용하는 Waves 샘플 전체를 RAM ( Memory ) 에 올려놓고 작업하는 방식입니다. ^_^ DAW 마다 가상악기의 소리 차이가 나는지를 테스트해보자 한다면, 같은 엔진 모드인지 확인하고 가능한 DFD 또는 Sampler 모드에서 테스트하는 것이 좋습니다. ( DFD / Sampler 모드의 차이는 오류에 가깝기 때문에 가상악기의 차이라긴 힘듭니다. ^_^) 고용량 가상악기를 HDD 대신 SSD 를 사용하는 것이 좋다라고 하는 이유 역시 HDD 에서 가상악기를 첫 로딩하는 시간을 줄여서 좀 더 쾌적하게 쓰기 위함도 있지만, DFD 나 유사한 엔진의 경우 일부 샘플 로딩되어 있는 것과 나머지 샘플 로딩하는 시간 차이를 줄이고 가끔 발생하는 오류를 줄이기 위함이 제일 크기 때문입니다.

'강좌 ( Lecture ) > Tip & etc' 카테고리의 다른 글

| 음악 프로그램 Mac OSX 10.15 Catalina 카탈리나 호환성 관련해서.... (2) | 2020.08.26 |

|---|---|

| 음원 파트별 분리 툴 - Spleeter Guide ( 스플리터 활용 기초 가이드 ) (1) | 2020.04.21 |

| 추천하는 프로젝트 메타정보 관리 플러그인 / 프로그램들 ( Recommended Project Metadata Plugins / Program ) (0) | 2019.10.01 |

| Waves 번들과 정책 관련 기초 가이드 ( Waves Bundle & Policy Basic Guide ) (0) | 2019.01.05 |

| 동일한 가상악기라도 DAW 가 다르면 다른 소리가 나는 것인가요? Part 1/2 ( DAWs... Do they sound different? ) (0) | 2018.11.30 |

| Waves 플러그인 최대 $50 추가 할인 받는 방법 가이드 ( 2018년 12월 31일까지 ) (0) | 2018.09.07 |

| Computer Music Magazine 을 이용해서 저렴하게 가상악기와 플러그인 구매 가이드 (0) | 2018.08.18 |

| 샘플이나 MR 의 Tempo / BPM 쉽게 바꾸기 with Audacity ( 심플 가이드 강좌 ) - 40번째 강좌 (0) | 2018.07.15 |